Robots.txt, bir web sitesindeki en basit dosyalardan biridir, ama aynı zamanda karıştırılması en kolay olanlar arasında yer alır.

Uygun olmayan bir karakter bile SEO’nuza zarar verebilir ve arama motorlarının sitenizdeki önemli içeriğe erişmesini engelleyebilir.

İşte bu yüzden robots.txt ile ilgili yanlış yapılandırmalar deneyimli SEO uzmanları arasında bile son derece sık karşılaştığımız bir durumdur.

Peki bu yazıda neler öğreneceksiniz?

- txt dosyası nedir?

- txt dosyası neye benzer?

- txt kullanıcı aracıları ve yönergeleri nelerdir?

- Bir robots.txt dosyasına ihtiyacınız var mı?

- txt dosyanızı nasıl bulursunuz?

- txt dosyanızı nasıl oluşturursunuz?

- En iyi robots.txt uygulamaları

- Örnek robots.txt dosyaları

- Sorunlarla karşılaştığınızda robots.txt dosyanızı nasıl denetleyeceksiniz?

- Robots.txt dosyası nedir?

- Robots.txt dosyası neye benzer?

- Robots.txt kullanıcı aracıları ve yönergeleri nelerdir?

- Bir robots.txt dosyasına ihtiyacınız var mı?

- Robots.txt dosyanızı nasıl bulursunuz?

- Robots.txt dosyanızı nasıl oluşturursunuz?

- En iyi robots.txt uygulamaları

- Örnek robots.txt dosyaları

- Sık Sorulan Sorular

Robots.txt dosyası nedir?

Robot.txt, arama motorlarına siteniz içerisinde nerelerde ilerleyebileceğini ve ilerleyemeyeceğini söyleyen dosyadır.

Öncelikle, Google gibi arama motorlarından saklamak istediğiniz tüm içeriği listeler.

Ayrıca, Google dışında bazı arama motorlarına da izin verilen içeriği nasıl tarayabileceklerini bildirebilirsiniz.

ÖNEMLİ NOT:

Çoğu arama motoru verdiğiniz izinlere uygun davranır.

Herhangi bir girişi kırma gibi alışkanlıkları bulunmamaktadır.

Bununla birlikte, bazıları ise birkaç kuralı bozmaktan çekinmezler.

Google bu arama motorlarından biri değildir.

Robots.txt dosyası içerisindeki talimatlara uymaktadırlar.

Ancak siz yine de bazı arama motorlarının bu kuralları tamamen görmezden geldiğini bilin.

Robots.txt dosyası neye benzer?

Burada robots.txt dosyasının temel formatını bulabilirsiniz:

Sitemap: [URL location of sitemap]User-agent: [bot identifier][directive 1][directive 2][directive ...]User-agent: [another bot identifier][directive 1][directive 2][directive ...]

Eğer bu dosyalardan herhangi birini daha önce görmediyseniz, size biraz korkutucu görünebilir.

Ancak, sözdizimi oldukça basittir.

Kısacası, yönergeler tarafından izlenen kullanıcı aracılarını belirterek botlara bazı kurallar atarsınız.

İsterseniz bu iki bileşeni daha ayrıntılı olarak inceleyelim.

Robots.txt kullanıcı aracıları ve yönergeleri nelerdir?

Kullanıcı Aracıları

Her arama motoru kendini farklı bir kullanıcı aracısı ile tanımlar.

Robots.txt dosyanız içerisinde bunların her biri için özel talimatlar ayarlayabilirsiniz.

Yüzlerce kullanıcı aracısı bulunmaktadır, ancak SEO için faydalı olanlardan birkaçı aşağıda sıralanmıştır:

Google: Googlebot

Google Images: Googlebot-Image

Bing: Bingbot

Yahoo: Slurp

Baidu: Baiduspider

DuckDuckGo: DuckDuckBot

Ufak bir not: Tüm kullanıcı aracıları robots.txt dosyasında büyük/küçük harfe duyarlıdır.

Bütün kullanıcı aracıları için geçerli olacak yönergeler atamak için yıldız (*) karakterini de kullanabilirsiniz.

Örneğin, Googlebot hariç tüm botların sitenizi taramasını engellemek istediğinizi varsayalım. Bu işlemi şu şekilde gerçekleştirebilirsiniz:

User-agent: *Disallow: / User-agent: GooglebotAllow: /

Robots.txt dosyanızın istediğiniz kadar kullanıcı aracısı için yönergeler içerebileceğini bilin.

Bununla birlikte, dosyanız her yeni bir kullanıcı aracısı bildirdiğinizde temiz bir sayfa işlevi görür.

Başka bir deyişle, eğer birden fazla kullanıcı aracısı için yönerge eklerseniz, ilk kullanıcı aracısı için bildirmiş olduğunuz yönergeler ikinci, üçüncü veya sonrakiler için geçerli olmayacaktır.

Bu kuralın istisnası olarak aynı kullanıcı aracısını bir kereden fazla bildirebilirsiniz. Bu durumda, ilgili tüm yönergeler birleştirilir ve takip edilir.

ÖNEMLİ NOT:

Tarayıcılar, sadece kendileri için tam olarak geçerli olan kullanıcı aracılarına göre belirtilen kuralları takip eder.

Bu yüzden yukarıda gösterilen robots.txt dosyası Googlebot (ve diğer Google botları) haricindeki tüm botların siteyi taramasını engeller.

Googlebot, daha az belirli olan kullanıcı aracısı bildirimini görmezden gelir.

Yönergeler

Yönergeler belirlediğiniz kullanıcı aracılarının takip etmesini istediğiniz kurallardır.

- Desteklenen yönergeler

Kullanımları ile birlikte Google’ın güncel bir şekilde desteklediği yönergeleri aşağıdaki gibidir:

Disallow (Engelle)

Arama motorlarına, belirli bir yol kapsamında olan dosya ve sayfalara erişmemeleri konusunda talimat vermek için bu yönergeyi kullanın. Örneğin, tüm arama motorlarının blogunuza ve tüm yayınlarınıza erişmesini engellemek istiyorsanız, robots.txt dosyanız şu şekilde olmalıdır:

User-agent: *Disallow: /blog

Ufak bir not: Eğer “engelle” yönergesinden sonra bir yol tanımlama işlemini gerçekleştiremezseniz, arama motorları bunu görmezden gelecektir.

Allow (İzin Ver)

Arama motorlarına, aksinin izin verilmediği dizinlerde bile, bir dizin veya bir sayfayı gezinme imkânı sağlamak için bu yönergeyi kullanın. Örneğin, eğer arama motorlarının biri hariç blogunuzdaki tüm gönderilere erişmesini engellemek istiyorsanız, o zaman robots.txt dosyanız şu şekilde olacaktır:

User-agent: *Disallow: /blogAllow: /blog/allowed-post

Bu örnekte arama motorları /blog/allowed-post kısmına erişebilirler ancak;

/blog/another-post/blog/yet-another-post/blog/download-me.pdf

kısımlarına erişemeyeceklerdir.

Hem Google hem de Bing bu yönergeyi desteklemektedir.

Ufak bir not: Engelle yönergesinde olduğu gibi, İzin Ver yönergesinden sonra da bir yol tanımlamazsanız, arama motorları bunu görmezden gelecektir.

ÇELİŞKİLİ KURALLAR İLE İLGİLİ BİR NOT:

Eğer dikkatli olmazsanız, izin verme ve izin ver yönergeleri kolaylıkla birbirleri ile zıt düşebilir. Aşağıdaki örnekte /blog/ erişimini engelliyor ve /blog erişimine izin veriyoruz.

User-agent: *Disallow: /blog/Allow: /blog

Bu durumda, /blog/post-title/ erişimine hem izin verilmiyor hem de izin veriliyor gibi görünmektedir. Peki bu durumda kazanan hangisi?

Google ve Bing için geçerli olan kural karakter sayısı en fazla olan yönergenin kazanması yönündedir.

Aşağıda engelle yönergesini bulabilirsiniz:

Engelle: /blog/ (6 karakter)

İzin Ver: /blog (5 karakter)

İzin ver ve engelle yönergelerinin uzunluğunun eşit olması durumunda, en az kısıtlayıcı olan yönerge kazanır.

Yani bu örnekte kazanan izin ver yönergesi olacaktır.

Ufak bir not: Bu örnekte /blog (sondaki eğik çizgi olmadan) hâlâ erişilebilir ve taranabilir.

En önemlisi, bu durum sadece Google ve Bing için geçerlidir. Diğer arama motorları ilk eşleşen yönergeyi dinleyecektir.

Bu durumda, yukarıdaki örnekte engelle seçeneği uygulanacaktır.

Site Haritası

Site haritalarınızın konumunu arama motorlarına belirtmek için bu yönergeyi kullanın.

Eğer bu konuya aşina değilseniz, site haritaları genellikle arama motorlarının taramasını ve dizine eklemesini istediğiniz sayfaları içermektedir.

Aşağıda site haritaları yönergesinin kullanıldığı robots.txt dosyasının bir örneğini bulabilirsiniz:

Sitemap: https://www.domain.com/sitemap.xmlUser-agent: *Disallow: /blog/Allow: /blog/post-title/

Peki, site haritalarınızı robots.txt dosyanıza dahil etmek ne kadar önemlidir?

Eğer Google Arama Konsolu aracılığıyla site haritalarınızı gönderdiyseniz, Google için artık bu işlem lüzumsuz olacaktır.

Ancak, Bing gibi diğer arama motorlarına site haritanızı nerede bulacağınızı söylemesi sebebiyle site haritalarınız için hâlâ iyi bir işlemdir.

Her “User Agent” için site haritası yönergenizi birçok kez tekrar etmenize gerek yoktur.

Yani sadece biri için uygulanmayacaktır.

Bu yüzden site haritası yönergelerinizi robots.txt dosyanızın başlangıcına ya da sonuna dahil etmeniz sizin için daha faydalı olacaktır. Örnek olarak;

Sitemap: https://www.domain.com/sitemap.xmlUser-agent: GooglebotDisallow: /blog/Allow: /blog/post-title/ User-agent: BingbotDisallow: /services/

Ask, Bing ve Yahoo gibi Google da site haritası yönergesini desteklemektedir.

Ufak bir not: Robots.txt dosyanıza istediğiniz kadar site haritaları ekleyebilirsiniz.

- Desteklenmeyen Yönergeler

Burada Google tarafından artık desteklenmeyen ve teknik olarak hiçbir zaman desteklenmemiş olan bazı yönergeleri bulabilirsiniz.

Crawl-delay (Tarama Geciktirme)

Önceden bu yönergeyi saniye cinsinde bir tarama geciktirme gerçekleştirmek için kullanabiliyordunuz. Örneğin, eğer Googlebot’un her bir tarama işleminden sonra 5 saniye beklemesini istiyorsanız, tarama geciktirme yönergesi ile şu şekilde ayarlama yaparsınız:

User-agent: GooglebotCrawl-delay: 5

Ancak Bing ve Yandex’in aksine Google artık bu yönergeyi desteklememektedir.

Buna ek olarak, özellikle büyük bir siteniz varsa, bu yönergeyi ayarlarken dikkatli olmanızda fayda var. 5 saniyelik bir tarama gecikmesi ayarlarsanız, botları günde en fazla 17.280 URL taramaları için sınırlandırırsınız.

Milyonlarca sayfanız varsa bu çok yararlı değildir, ancak küçük bir web siteniz varsa bu işlem ile bant genişliğinden tasarruf edebilirsiniz.

Noindex

Bu yönerge hiçbir zaman Google tarafından resmi olarak desteklenmemiştir.

Ancak yakın zamana kadar, Google’ın Noindex gibi desteklenmeyen ve yayınlanmamış kuralları işleyen bir koda sahip olduğu düşünülmekteydi.

Böylece, eğer Google’ın bloğunuzdaki tüm gönderileri dizinlemesini önlemek istiyorsanız, aşağıda sıralanan yönergeleri kullanabilirsiniz.

User-agent: GooglebotNoindex: /blog/

Ancak, 1 Eylül 2019 tarihinde Google bu yönergenin kendisi tarafından desteklenmediğini belirterek bu konuya bir açıklık getirdi.

Eğer bir sayfayı ya da dosyayı arama motorlarından çıkartmak istiyorsanız, bunun yerine Meta Robot Etiketini ya da X-Robots HTTP başlığını kullanabilirsiniz.

Nofollow

Nofollow yönergesi Google’ın hiçbir zaman resmi olarak desteklemediği ve arama motorlarının belirli bir yol kapsamındaki sayfa ve dosyalardaki linkleri takip etmesini önleyen bir diğer yönergedir.

Örneğin, eğer Google’ın bloğunuzdaki tüm linkleri takip etmesini engellemek istiyorsanız, aşağıdaki yönergeyi kullanabilirsiniz.

User-agent: GooglebotNofollow: /blog/

Yine 1 Eylül 2019’da Google bu yönergenin resmi olarak desteklenmediğini açıklamıştır.

Artık bir sayfadaki bütün linkler üzerinde takip etme direktifini uygulamak istiyorsanız, Meta Robot Etiketini ya da X-Robots başlığını kullanmalısınız.

Eğer Google’a bir sayfa üzerindeki belirli linkleri takip etmemesini söylemek isterseniz rel=“nofollow” bağlantı özelliğini kullanın.

Bir robots.txt dosyasına ihtiyacınız var mı?

Bir robots.txt dosyası, özellikle küçük siteler olmak üzere, birçok web site için kritik bir öneme sahip değildir.

Yine de bir robots.txt dosyasına sahip olmamak için bir sebep yok.

Robots.txt dosyası arama motorlarının web siteniz üzerinde nerelere erişip nerelere erişemeyeceği konusunda size daha fazla kontrol imkânı sunar.

Ayrıca, aşağıdaki gibi konularda size yardım sağlar:

- Yinelenen içeriğin taranmasını önleme

- Bir web sitesinin bölümlerini gizli tutmak (örnek olarak Staging Site verilebilir.)

- Dahili arama sonuçları ile ilgili sayfaların taranmasını önleme

- Sunucu aşırı yüklenmesini önleme

- Google’ın “tarama bütçesi” konusunda israfını önleme

- Resim, video ve kaynak dosyalarının Google arama sonuçlarında görünmesini önleme

Lütfen Google’ın robots.txt dosyasında engellenen web sayfalarını dizine eklemediğinde, robots.txt dosyasını kullanarak arama sonuçlarının dışında kalmayı garantilemenin bir yolu olmadığını unutmayın.

Google’ın dediği gibi, eğer içerik internet ağındaki diğer yerler ile bağlantılıysa, Google arama sonuçlarında görünmeye devam edebilir.

Robots.txt dosyanızı nasıl bulursunuz?

Eğer hali hazırda web siteniz üzerinde bir robots.txt dosyasına sahipseniz, domain.com/robots.txt adresi üzerinden ona erişebilirsiniz.

Tarayıcınızdaki URL adresine gidin.

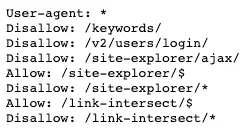

Eğer aşağıdaki gibi bir şey görüyorsanız, robots.txt dosyasına sahipsiniz demektir:

Robots.txt dosyanızı nasıl oluşturursunuz?

Eğer bir robots.txt dosyasına sahip değilseniz, merak etmeyin yeni bir tane oluşturmak kolay bir işlem.

Sadece boş bir .txt belgesi açın ve yönergeleri yazmaya başlayın.

Örneğin, eğer tüm arama motorlarının /admin/ dizininizde gezinmesini engellemek istiyorsanız, yazacağınız yönerge şu şekilde olacaktır:

User-agent: *Disallow: /admin/

Sonuç sizi memnun edene kadar bu dosyadaki yönergeleri arttırabilir ve düzenleyebilirsiniz.

Daha sonra dosyanızı “robots.txt.” olarak kaydedin.

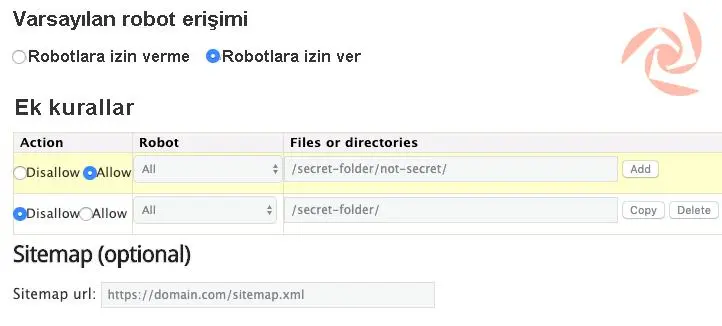

Alternatif olarak, aşağıdaki gibi bir robots.txt dosyası oluşturucu kullanabilirsiniz.

Bu gibi bir aracı kullanmanın avantajı olarak sözdizimi hatalarının en aza indirilmesi gösterilebilir.

Bu çok önemli bir durum çünkü hazırladığınız yönergedeki tek bir hata bile siteniz için büyük bir SEO felaketi ile sonuçlanabilir.

Dezavantajı ise özelleştirilebilirlik açısından oldukça sınırlı olmalarıdır.

Peki bir robots.txt dosyasını nereye koyabilirsiniz?

Robots.txt dosyanızı, uygulandığı alt domain alanının kök dizinine yerleştirin.

Örneğin, domain.com’da gerçekleştirilen tarama hareketini kontrol etmek için, robots.txt dosyası domain.com/robots.txt adresinden erişilebilir olmalıdır.

Eğer blog.domain.com gibi bir alt domain alanındaki taramayı kontrol etmek istiyorsanız, robotlar.txt dosyası blog.domain.com/robots.txt adresinden erişilebilir olmalıdır.

En iyi robots.txt uygulamaları

Sıklıkla yapılan hatalardan kaçınmak istiyorsanız bunu aklınızda bulundurun:

- Her bir yönerge için yeni bir satır kullanın.

Her bir yönerge yeni bir satıra yazılmalıdır. Aksi halde, arama motorlarının kafasını karıştırır.

Kötü:

User-agent: * Disallow: /directory/ Disallow: /another-directory/

İyi:

User-agent: * Disallow: /directory/Disallow: /another-directory/

- Açıklamalarınızı basitleştirmek için yıldız (*) karakterini kullanın.

Yıldız (*) karakterini sadece tüm kullanıcı aracılarına yönergeleri uygulamak için değil, aynı zamanda yönergeleri verirken URL şablonlarını eşleştirmek için kullanabilirsiniz.

Örnek olarak, arama motorlarının web sitenizdeki parametreli ürün kategorisi URL’lerine erişimini engellemek istiyorsanız, bunları aşağıdaki gibi sıralayabilirsiniz:

User-agent: *Disallow: /products/t-shirts?Disallow: /products/hoodies?Disallow: /products/jackets?…

Ama bu çok uygun bir hareket değil. Ürünleri yıldız (*) karakteri kullanarak sadeleştirmek daha etkili bir yol olacaktır.

User-agent: *Disallow: /products/*?

Verilen bu örnek, arama motorlarının soru işareti içeren ve /product/ alt klasörü altında yer alan tüm URL’leri taramasını engeller.

Diğer bir deyişle, bu hareket arama motorlarının herhangi bir parametreli ürün kategorisi URL’lerine erişimini önler.

- Bir URL’nin sonunu belirtmek için “$” kullanın.

“$” karakteri, bir URL’nin sonunu işaretlemek için kullanılır.

Örnek vermek gerekirse, eğer arama motorlarının sitenizde yer alan .pdf uzantılı dosyaların tümüne erişimini engellemek istiyorsanız, robots.txt dosyanız şu şekilde olmalıdır:

User-agent: *Disallow: /*.pdf$

Bu örnekte gösterilen işlem ile arama motorları sonu .pdf ile biten hiçbir URL’ye erişim sağlayamayacaktır.

Bu, arama motorlarının sonu /file.pdf ile biten URL’ye erişemeyecekleri, ancak “.pdf” ile sonlanmaması sebebiyle sonu /file.pdf?id=68937586 ile biten URL’lere erişebilecekleri anlamına gelmektedir.

- Her bir kullanıcı aracısını sadece bir kez kullanın.

Eğer aynı kullanıcı aracısını birden çok kez belirtirseniz, Google bunu önemsemeyecektir.

Çeşitli bildirimlerden gelen tüm kuralları bir araya getirecek ve hepsini o şekilde takip edecektir.

Örneğin, robots.txt dosyanızda aşağıdaki kullanıcı aracıları ve yönergeleri var ise Googlebot bu alt klasörlerden herhangi birini taramayacaktır.

User-agent: GooglebotDisallow: /a/ User-agent: Googlebot Disallow: /b/

Buna ek olarak, daha az kafa karıştırıcı olması sebebiyle her kullanıcı aracısını yalnızca bir kez bildirmek daha mantıklıdır.

Diğer bir deyişle, işleri düzenli ve basit tutarak kritik hatalar yapma olasılığınızı düşürebilirsiniz.

- İstenmeyen hataları önlemek için belirgin talimatlar verin.

Yönergeleri ayarlarken belirgin talimatların verilmemesi, kolayca gözden kaçırılabilen ve SEO’nuz üzerinde kötü etki bırakabilecek hatalara neden olabilir.

Örneğin, çok dilli bir siteniz olduğunu ve /de/ alt dizininde bulunan bir Almanca sürümü üzerinde çalıştığınızı varsayalım.

Henüz tam olarak yayınlamaya hazır olmadığı için burada yer alan bilgilerin arama motorları tarafından görülmesini engellemek istiyorsunuz.

Aşağıdaki robots.txt dosyası ile arama motorlarının bu alt klasöre ve içinde bulunan her bilgiye erişini engelleyebilirsiniz:

User-agent: *Disallow: /de

Ancak bu işlemin, arama motorlarını /de ile başlayan herhangi bir sayfa veya dosyayı taraması konusunda da engelleyeceğini unutmayın.

Örneğin:

/designer-dresses/

/delivery-information.html

/depeche-mode/t-shirts/

/definitely-not-for-public-viewing.pdf

Bu varsayımda, çözüm ise oldukça basit: Sonuna bir adet eğik çizgi ekleyin.

User-agent: *Disallow: /de/

- txt dosyanızı insanlara açıklamak için yorumlar ekleyin.

Yorumlar, robots.txt dosyanızı geliştiricilere açıklamanıza ve hatta ilerleyen zamanlarda kendinize ne için hazırlandığını hatırlatmanızda yardımcı olur.

Bir yorum eklemek için satırın başına bir adet kare (#) karakteri ekleyin.

# This instructs Bing not to crawl our site.User-agent: BingbotDisallow: /

Tarayıcılar kare (#) karakteri ile başlayan satırlardaki her şeyi görmezden gelecektir.

- Her bir alt alan için ayrı robots.txt dosyası kullanın.

Robots.txt yalnızca yer aldığı alt alan üzerindeki tarama davranışlarını kontrol eder.

Eğer farklı alt alanlarda tarama davranışlarını kontrol etmek istiyorsanız ayrıca bir robots.txt dosyasına ihtiyacınız olacak.

Örnek olarak, ana siteniz domain.com üzerinde ve blogunuz ise blog.domain.com üzerine kayıtlı ise o zaman iki adet robots.txt dosyasına ihtiyacınız olacaktır.

Bir tanesinin ana alanının kök dizinine, diğerinin ise bloğun kök dizinine yerleşmesi gerekir.

Örnek robots.txt dosyaları

Aşağıda birkaç tane robots.txt dosyası örneği bulabilirsiniz.

Bu örnekler çoğunlukla sizlere yol göstermesi için hazırlanmıştır ancak eğer ihtiyaçlarınız ile eşleşen bir tanesi var ise o örneği bir adet metin dosyası içerisine kopyala-yapıştır yaparak dosyayı “robots.txt” olarak kaydedebilir ve uygun bir dizine yükleyebilirsiniz.

- Tüm botlar için tam erişim

User-agent: *Disallow:

Ufak bir not: Bir yönergeden sonra bir URL’nin bildirilmemesi, bu yönergeyi gereksiz kılar.

Diğer bir deyişle, arama motorları o yönergeyi göz ardı eder.

Bu sebeple Disallow (Engelle) yönergesinin site üzerinde hiçbir etkisi yoktur ve arama motorları sayfaları ve dosyaları taramaya devam eder.

- Hiçbir bot için erişim yok

User-agent: *Disallow: /

- Tüm botlar için bir alt dizini engelle

User-agent: *Disallow: /folder/

- Tüm botlar için izin verilen bir dosya dahil bir alt dizini engelle

User-agent: *Disallow: /folder/Allow: /folder/page.html

- Bir dosyayı tüm botlar için engelle

User-agent: *Disallow: /this-is-a-file.pdf

- Bir dosya tipini (PDF) tüm botlar için engelle

User-agent: *Disallow: /*.pdf$

- Yalnızca Googlebots için tüm parametreli URL’leri engelle

User-agent: GooglebotDisallow: /*?

Robots.txt dosyanızın hatalarını nasıl denetleyebilirsiniz?

Robots.txt hataları kolay bir şekilde ağ üzerinde gözden kaçabilir bu sebeple her türlü problemi dikkatli bir şekilde takip etmek gerekir.

Bunu yapmak için, düzenli olarak Arama Konsolu’ndaki “Coverage (Kapsam)” raporundaki robots.txt ile ilgili sorunları kontrol edin.

Aşağıda karşılaşabileceğiniz hatalardan bazılarının ne anlama geldiğini ve nasıl onarılabileceği ile ilgili bilgilendirmeleri bulabilirsiniz.

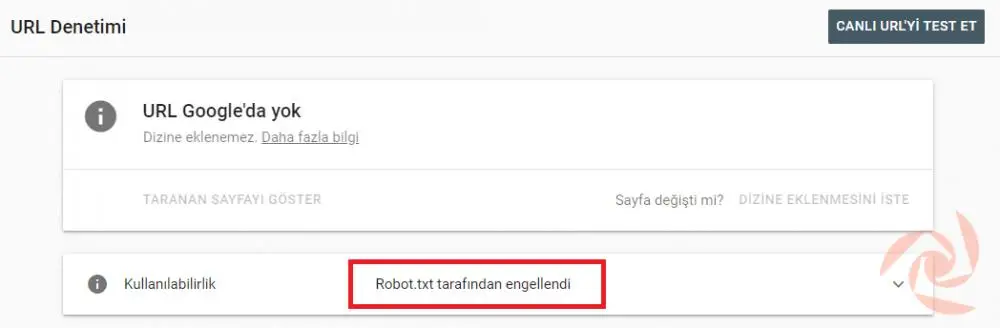

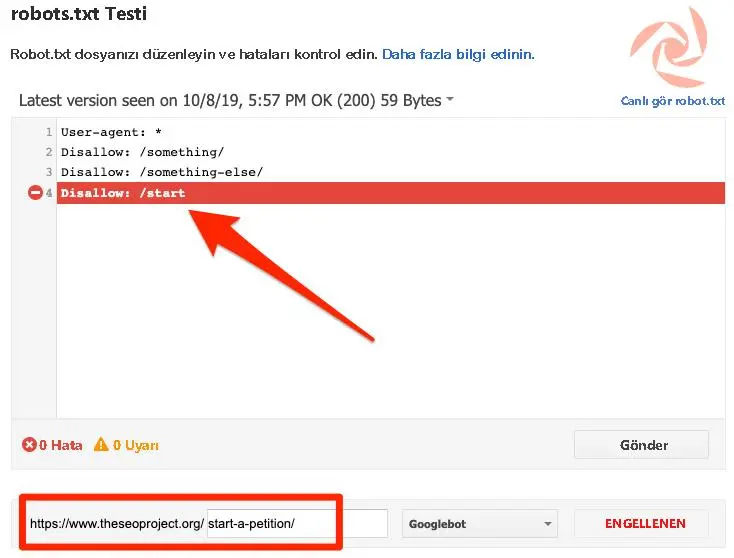

BELİRLİ BİR SAYFADAKİ HATALARI KONTROL ETMENİZ Mİ GEREKİYOR?

Arama Konsolu’ndaki Google’ın URL Kontrol Aracı’na bir URL yapıştırın.

Eğer robots.txt tarafından engelleniyorsa aşağıdaki gibi bir yazı ile karşılaşacaksınız:

“Gönderilen URL Robots.txt tarafından engellendi”

Bu göndermiş olduğunuz site haritalarındaki URL’lerden en az bir tanesinin robots.txt tarafından engellendiği anlamına gelmektedir.

Site Haritanızı doğru bir şekilde oluşturduysanız ve standartlaştırılmış, indekslenmiş ve yeniden yönlendirilmiş sayfaları hariç tuttuysanız, gönderilen hiçbir sayfa robots.txt tarafından engellenmeyecektir.

Ancak eğer engellemişse, hangi sayfaların etkilendiğini araştırın, sonrasında bu sayfadaki bloğu kaldırmak için uygun olacak şekilde robots.txt dosyalarını ayarlayın.

Google’ın Robots.txt Tester aracını kullanarak, içeriğin hangi yönerge tarafından engellendiğini görebilirsiniz.

Ancak bunu yaparken lütfen dikkatli olun.

Bu aşamada diğer sayfaları ve dosyaları etkileyecek küçük hatalar yapmak çok kolaydır.

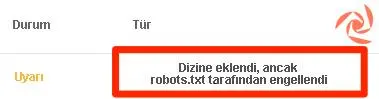

“Robots.txt tarafından engellenme”

Bu açıklama, güncel olarak Google tarafından dizine eklenmeyen ve robots.txt tarafından engellenen içeriğe sahip olduğunuz anlamına gelir.

Eğer bu içerik önemliyse ve dizine eklenmesi gerekliyse robots.txt dosyası içerisindeki tarama engelini kaldır.

Ayrıca, içeriğin dizine eklenmediğinden emin olmak gerekmektedir.

Eğer Google’ın dizininden hariç tutma amacıyla robots.txt içerisindeki içeriği engellediyseniz, tarama engelini kaldırın ve bunun yerine bir Meta Robot Etiketi ya da X-Robots başlığı kullanın.

Bu işlem içeriği Google’ın indeksinin dışında tutmayı garantilemenin tek yoludur.

Ufak bir not: Bir sayfayı arama sonuçlarından hariç tutmaya çalışırken tarama engelini kaldırmak çok önemlidir.

Eğer bunu yapmazsanız, Google noindex etiketini veya HTTP başlığını görmeyecek ve bu nedenle sayfa dizine eklenecektir.

“Robots.txt tarafından engellenmiş olsa da indeksli”

Bu, robots.txt tarafından engellenen içeriğin bir kısmının hâlâ Google’da dizine eklendiği anlamına gelir.

Bir kez daha hatırlatmakta fayda var: Bu içeriği Google’ın arama sonuçlarının dışında tutmaya çalışıyorsanız, robots.txt doğru çözüm değildir.

Tarama engelini kaldırın ve bunun yerine indekslemeyi önlemek için bir Meta Robot Etiketi ya da X-Robots-Etiketi HTTP başlığı kullanın.

Eğer bu içeriği yanlışlıkla engellediyseniz ve Google’ın dizininde tutmak istiyorsanız, robots.txt’deki tarama engelini kaldırın.

Bu işlem, Google aramasındaki içeriğin görünürlüğünü arttırmaya yardımcı olabilir.

Web sitenizin Google gibi arama motorlarında üst sıralarda çıkmasını mı istiyorsunuz? Bu işi profesyonel SEO ajansına bırakın!

Sık Sorulan Sorular

Robots.txt ve SEO ile ilgili merak ettiğiniz başka şeyler varsa aşağıda sık sorulan birkaç soruyu bulabilirsiniz. Eksik gördüğünüz bir konu var ise lütfen yorumlarda bize bildirin.

- Robots.txt dosyasının maksimum boyutu kaçtır?

500 kilobayt (Yaklaşık)

- WordPress’te robots.txt dosyasını nerede bulabilirim?

Aynı yerde (Genelde ana dizinde olur) bulabilirsiniz: domain.com/robots.txt.

- WordPress’te robots.txt dosyasını nasıl düzenleyebilirim?

İster manuel olarak isterseniz de robots.txt dosyalarını düzenlemenizi sağlayan Yoast gibi WordPress SEO eklentilerini kullanabilirsiniz.

- Robots.txt’de noindexed içeriğe erişime izin vermezsem ne olur?

Google, sayfayı tarayamadığı için noindex yönergesini asla görmeyecektir.